🕵️♂️ Агент - полиграф.* 📠

Пользователи вашего сервиса присылают вам на проверку различные факты, которые они прочитали где-то в Интернете или услышали от друзей, и хотят, чтобы вы подтвердили или опровергли его.

Создайте агента, который смог бы отвечать на вопросы из широкого спектра областей

знаний от математических примеров до научных фактов. Отвечать надо в формате:

правда или ложь. На некоторые вопросы, возможно, агент не сможет ответить без

вашей помощи, например про преподавателей курса 🙈, поэтому надо будет использовать

инструмент "human", о котором упоминали в ноутбуке урока.

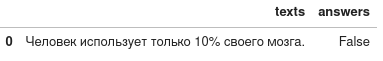

Вам даётся датасет содержащий набор различных фактов,

напротив которых в столбце 'answers' нужно проставить:

True или False

(True, а не строку: 'True').

Пример строки ответа: